星河研究院:揭秘AI+成功的五要素

发布时间:2017/3/26 9:56:19 作者:佚名 点击:

李瑶博士曾为我们详细的介绍过什么是AI,什么是深度学习。当前的趋势,正在从之前的“互联网+”或者“移动+”,慢慢转向为“AI+”,也就是“人工智能+”。很多公司比如滴滴是“互联网+打车”,做的是怎样用互联网改变传统行业;但是现在,他们纷纷转向“如何用积累下来的数据提供更多的价值”。一些公司从创立初始就是“人工智能+”,比如今日头条是“人工智能+新闻”、大疆是“人工智能+无人机和机器人”。可以看到,“人工智能+”正在慢慢渗透并在改变所有的行业。

那为什么人工智能在 20 年前、10 年前没有这么火?为什么 AlphaGo 能在2016年打败李世石而不是更早?为什么人工智能会在2016年爆发?我们会直观地认为是因为算法创新。但是国内外很多专家分析总结出了人工智能成功的五个必要条件,我们经过整理后在这里跟大家分享一下:

第一是边界清晰。问题需要定义得非常清晰,比如 AlphaGo 做的就是围棋,活动范围就是在 19×19 的棋盘上,黑白两方轮流下子,边界和规则都很清晰。如果变成一个开放的问题,或者变成20×20 的棋盘,或者变成黑白灰三方下棋,那都成不了。

第二是要有外部反馈。算法要不断地有外部输入,它需要知道在什么样的情况、什么样的行为下,外部给出的反馈是什么,这样才能促进提高。比方说AlphaGo ,你要不断地让它进行对弈,并且告诉它对弈的输赢,它才能不断提升。

第三是要重视计算资源。计算资源,也就是计算过程中需要的各种资源。近几年,算法虽然有很大的进步,但计算资源也是产生智能的关键。最近业界在分布式计算上的成功,让我们相对于几十年前有了飞跃的基础。举个很有趣的例子,Google 在描述 AlphaGo 不同版本的时候,为了简洁明了,直接使用计算能力来分类,而不是使用算法来分类。简版的 AlphaGo 被称为“单机训练的AlphaGo”;复杂和更高智能的 AlphaGo 称为“多机、并行训练的 AlphaGo”,从这里也可以看出来,计算资源起着至关重要的作用。

第四,要有顶尖的数据科学家和人工智能科学家。增强学习、深度学习最近重新被提出,需要很多科学家做大量的工作,才能让这些算法真正地推行。除了围棋、视觉、语音之外,还有非常多的领域等待被探索。

第五是大数据的完善。AlphaGo的成功,关键的一点是 KGS 棋社的流行,KGS是一个免费的围棋对弈平台,KGS上有数十万盘高手对战的棋谱,如果没有这些数据做支撑,AlphaGo 绝对不可能在这么短的时间内打败人类。

我们把以上这些人工智能成功的要素归结为三点,那就是要关注技术、关注业务、关注人。一方面,要有技术、计算资源和大数据方面的支持;另一方面,业务、边界要清晰,业务要有反馈;再有就是人,要有科学家,一些应用到场景也需要和人打交道。我们会持续与你讨论人工智能对各个产业的改造,今天我们和星河研究院的研究经理李瑶博士与你分享人工智能从量变到质变的原因以及人工智能的未来,希望对你有所帮助。

星河融快(ID:rongkuai888)将通过专业的分析,持续与你分享“有趣的”产业互联网干货。欢迎你在下方留言和我们分享有趣的观点,自荐或推荐优质产业互联网项目,同时也欢迎你来上地18号和我们聊聊。

人工智能研究的开始可以追溯到1956年,直到2015年,人工智能都基本上是只存在于实验室的技术。2016年,是人工智能诞生60周年,人工智能技术也在积累了足够的量变之后,迎来了质的变化。

第一

哪些量变带来了AI的质变 ?

1.1 不断改进的算法——CNN和RNN

深度学习其实不是新技术——第一个有效的多层神经网络的规范发布于1965年——但过去十年深度学习算法的改进大大的改善了结果的准确性。

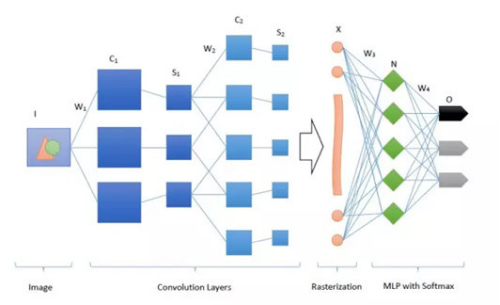

卷积神经网络

通过卷积神经网络(CNN)的发展,机器识别图像中某个特定对象的能力大大提高。在受动物的视觉皮层启发的设计中,神经网络中的每个层级都充当这个对象的某一个特定模式的过滤器。2015年,微软基于CNN的计算机视觉系统比人类更有效的识别图片中的对象(95.1%的准确性,人类94.9%的准确性)。CNN更广泛的应用是在视频和语音识别中。

与此同时,循环神经网络(RNN)的出现推动了语言和手写识别的进步。RNN的反馈系统可以使数据循环流动,这不同于传统的只有“前馈”的神经网络。强大的新型RNN是一种叫做“长短期记忆”(LSTM)的模型。随着新加入的连接和存储单元,RNN可以“记住”它们在数千步之前看到的数据,并且使用这些数据对之后的内容进行判断。这对于语音识别是有价值的——对于下一个词的判断可以由前面的词来确定。自2012年起,Google就开始使用LSTM在Android系统中进行语音识别。2016年底,微软的工程师发布了一个数据说他们的系统达到了5.9%的错误率,这是历史上第一次能达到与人类相当的水平。

1.2 专用硬件——GPU

图形处理单元(Graphical Processing Units, GPU)是一种特殊的电子电路,它可以大大缩短深度学习神经网络训练所需要的时间。

GPU最初是在20世纪90年代末开发的,用于加速3D游戏和3D开发应用程序。在3D环境中平移或缩放摄像头重复的用到了一个数学过程叫做矩阵计算,而具有串行体系结构的微处理器,包括现代计算机里用到的CPU并不适合进行矩阵计算。GPU采用大规模的并行架构,可有效的执行矩阵计算。

神经网络的训练普遍要使用矩阵计算,因此原来只用于3D游戏的GPU被发现非常适合用来进行深度学习。它的效果非常可观:一个简单的GPU可以将训练神经网络的时间提高5倍,如果是更复杂的问题,则可以提高10倍的效率。如果与针对广泛使用深度学习框架的软件开发工具包一起使用的话,可能达到更高的训练速度。

1.3大数据——每天23亿GB

深度学习的神经网络通常需要大数据集进行训练(几百万个例子),幸运的是,当前数据的创造和可用性呈指数级增长。今天,我们进入了数据爆炸的“第三次浪潮“,人类每天产生23亿GB的数据,而且全球数据的90%都是在过去的24个月内创造的。

数据爆炸的“第一次浪潮”始于上世纪80年代的文件和交易数据的激增,这是由于台式电脑可以进行互联网连接造成的。“第二次浪潮”的出现是由于非结构化媒体(Email、照片、音乐和视频)、网络数据和元数据的爆炸式增长。今天,我们进入了“第三次浪潮”,工业和家庭中部署的传感器正在制造更多的监控、分析和元数据。

今天所创造的大量数据都是通过互联网传输使用的,因此互联网的流量成为了衡量人类数据生产的指标。让我们来做一个对比,就可以看到我们现在是处在一个什么样数据规模的时代,在1992年,人类每天传输100GB的数据,到2020年,我们将每秒传输6.1万GB的数据。

除了一般数据可用性的增加,专家数据资源的增多更催化了机器学习的进步。例如ImageNet,是一个免费的拥有超过1000万个手工标记图像的数据库。它的存在加速了图像分类的深度学习算法的发展。

1.4 云服务

开发人员对机器学习使用的增加与越来越多的基于云的机器学习基础架构和服务的出现是分不开的。谷歌、亚马逊、微软和IBM都提供云基础架构(建模和迭代、可扩展GPUaaS和相关托管服务的环境),以降低开发机器学习功能的成本和难度。

此外,云服务提供商还提供一系列机器学习的云服务(从图像识别到语言翻译),开发人员可以直接在自己的应用程序中使用。谷歌机器学习(Google Machine Learning)提供以下服务:视觉(对象识别、显式内容检测、人脸识别和图像情绪分析)、语音(语音识别和语音-文字转换)、文本分析(命名实体识别、语义分析、语言检测和翻译)和员工工作搜索(机会表达和资历匹配)。微软的认知服务也包括视觉、语言、知识和搜索等21项服务。

1.5 兴趣和创业

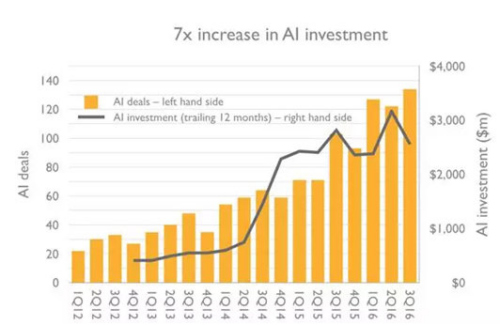

在过去的五年中,公众对人工智能的兴趣增加了6倍,风险投资对人工智能公司的投资数量也进一步增加。我们已经进入了一个良性循环,机器学习的进步可以吸引投资、创业和关注,而后者又进一步推动了机器学习的进展。

人工智能投资数量和投资金额

人工智能投资数量和投资金额

第二

人工智能的未来

在未来的几年,人工智能将在几乎所有的行业、各种流程中得以很好的利用。机器学习将会成为开发人员标准工具包的一部分,最初用来改进已有的流程,最后重新发明新的流程。就拿每个公司都有的职能部门HR来说,机器学习就可以应用在以下几个方面:

•精准寻找目标、智能工作匹配和部分自动化评估——以改善招聘

•根据人员需求的预测性规划和缺勤的预测——来加强劳动力管理

•根据不同员工进行不同的内容推荐——来提高员工培训效率和有效性

•根据预测有价值的员工离职的可能性分析——来减少员工流失风险等等

除了这些人工智能的直接应用外,它的间接应用同样会对行业产生深刻影响。例如,深度学习改善了计算机视觉,因此无人驾驶成为了可能。而无人驾驶的出现,有可能会影响整个物流行业,从安全到供应链规划等。

扎克伯格说过,“未来五到十年,人工智能会比人类更善于做一些最基础的任务”。我认为他是对的,在未来,人工智能会像水和电一样成为“通用”的技术。但仍然有一部分人对人工智能的爆发产生了焦虑甚至是恐惧的情绪,他们认为人工智能如果比人类还聪明,会使一大部分的人未来失去工作的机会,甚至是机器有了智能之后会将整个人类毁灭。但我认为恰恰是这种对技术的敬畏才能激励我们去更多的思考、创新,才能不被强大的人工智能所替代。我们错综复杂的大脑是大自然给人类最好的馈赠,所以我们要利用这份馈赠多学习、多思考、多创新,去迎接AI时代的到来。

上一篇:彭博社:人工智能将打造全新百度

下一篇:智慧安防大数据云平台发展中心成立